DeepSeek 推出 DeepSeek-OCR,以視覺壓縮技術重新定義長文本處理

By Sean Chen, 2025年10月21日

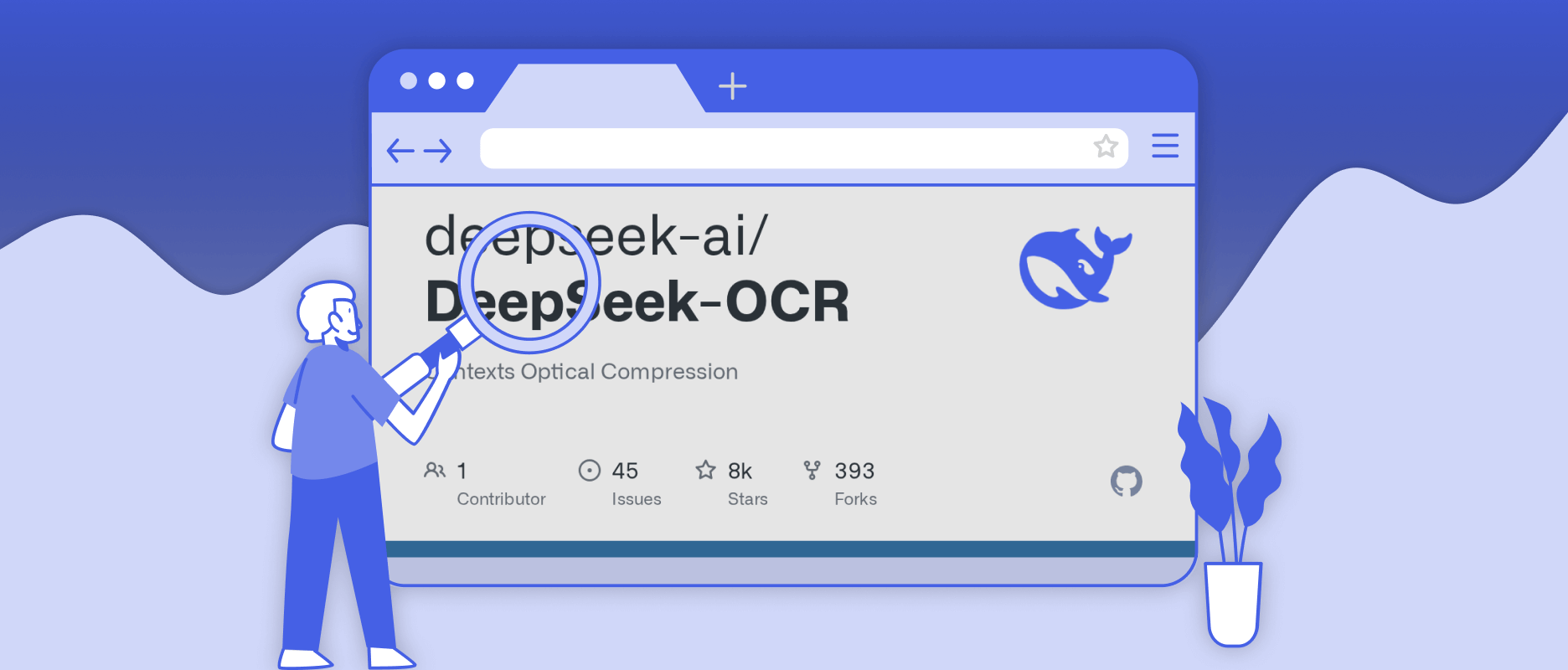

中國人工智慧公司 DeepSeek 週二(10 月 21 日)正式發表全新開源模型 DeepSeek-OCR,這是一款結合視覺編碼與文字理解的多模態模型,主打「將文字視覺化」的壓縮技術,能在維持理解能力的同時,大幅降低 LLM 處理長篇文本所需的運算成本。該模型目前已於 GitHub 上開源,並支援多種運行規模設定。

DeepSeek-OCR 的誕生,延續了 DeepSeek 系列在多模態研究上的路線。相較於傳統 OCR 僅進行「影像轉文字」的辨識,這款新模型採取反向思維,將大量文字內容先轉化為「視覺標記(visual tokens)」再進行壓縮,使語言模型能以影像形式閱讀與理解文本。根據官方資料,該技術可將長達 1,000 字的文章壓縮至僅約 100 個視覺 token,運算效率提升數倍。

最初,DeepSeek 的 OCR 研究著重於文件辨識與結構重建,如表格、圖表與手寫文字等識別任務。如今 DeepSeek-OCR 將此能力擴展至「長文本壓縮與語義保存」,讓模型不僅能辨識內容,更能理解段落邏輯與上下文語意。開發人員可將整份文件、合約或報告轉為影像輸入,再由 DeepSeek-OCR 自動生成摘要、問答回覆或結構化資料。

DeepSeek 表示,DeepSeek-OCR 支援多種輸入解析度設定:從 512×512 的 Tiny 版到 1280×1280 的 Large 版,皆可靈活選擇視覺 token 數量,以平衡效能與資源使用。實測中,單張 NVIDIA A100 GPU 每日可處理高達 20 萬頁文件,運算量較傳統文字輸入方式降低 7 至 20 倍。

簡而言之,DeepSeek-OCR 正從「文字識別工具」演變為「視覺壓縮的語義理解引擎」。

DeepSeek 指出,該模型特別適合應用於長篇文件摘要、自動化資料標註、企業報告分析與法律契約審閱等場景。開源版本目前已在 GitHub 上提供 MIT 授權下載,允許研究人員與開發者自由試驗與整合。